Estén de lleno o no en el mundo del emprendimiento y la tecnología, creo que fue imposible no escuchar hablar de la revolución china en inteligencia artificial esta semana.

DeepSeek un empresa desconocida por los lares occidentales, logró crear un modelo de inteligencia artificial a la altura de las grandes empresas como OpenAI, Anthropic, Google y Microsoft a una fracción del costo.

¿Y cómo puede ser que hayan hecho esto?

La respuesta está en la capacidad de utilizar la creatividad y la innovación para superar barreras y restricciones convencionales. DeepSeek no solo cambió el juego en términos de tecnología de IA, sino que también puso en evidencia una lección muchas veces mencionada en Creative Workout: los límites pueden ser increíbles catalizadores de innovación disruptiva. Es un recordatorio de cómo Sony, en los años 70, transformó la industria del audio al crear el Walkman. Enfrentados a la restricción de hacer un reproductor que entrara en los bolsillos de cualquier persona con la tecnología de la época, los ingenieros de Sony tomaron la decisión radical de eliminar la función de grabación de las grabadoras portátiles existentes, algo que parecía impensable entonces. Esta restricción autoimpuesta los llevó a reinventar completamente el concepto de música portátil, tal como ahora DeepSeek está redefiniendo el desarrollo de IA desde sus propias limitaciones.

Creo que podría dedicar dos ediciones de Creative Workout sólo para los memes que circularon en relación a este tema.

Sobre la caída de la bolsa:

Sobre la siesta de Europa:

Pero tenemos entre manos un gran ejemplo de cómo Deepseek superó a los nombres más grandes de la industria de la inteligencia artificial con creatividad e innovación.

Empecemos por el principio como decía mi abuelo.

Las grandes empresas de Inteligencia Artificial como OpenAI o Anthropic, desarrollan modelos de Inteligencia Artificial. Estos modelos son un conjunto de reglas y algoritmos que permiten a una computadora aprender y tomar decisiones o hacer predicciones basadas en datos. En lugar de programar a la máquina para hacer tareas específicas, el modelo de IA aprende de ejemplos (como imágenes, texto o datos numéricos) y mejora con el tiempo a medida que recibe más información.

Por ejemplo, si quieres que una IA reconozca fotos de gatitos, le mostrás muchas fotos de gatitos y otras cosas. El modelo de IA observa las características comunes en las fotos de gatos (sean las orejas, los ojos, etc...) y aprende a identificar los gatos en nuevas fotos que nunca ha visto antes.

Ese entrenamiento es increíblemente caro. Para que se den una idea, las empresas que desarrollan modelos top (los más usados mundialmente) gastan más de 100 millones de dólares solo en entrenamiento. Para hacer esto, necesitan centros de datos masivos con miles de GPUs.

Un GPU es una Unidad de Procesamiento Gráfico, un tipo de chip especializado, que nació para para manejar y acelerar los gráficos en las computadoras, principalmente para que juegos y videos se vieran más suaves y rápidos. Pero gracias a su poder de procesamiento, hoy también se utilizan para entrenar modelos de inteligencia artificial o realizar cálculos científicos.

La gran diferencia con un CPU (Unidad Central de Procesamiento), que es el cerebro principal de una computadora, es que un GPU tiene muchos más núcleos de procesamiento, lo que le permite manejar una gran cantidad de cálculos al mismo tiempo. Esto es ideal para edición de gráficos o el entrenamiento de redes neuronales en IA, donde se necesita procesar mucha información de manera rápida y en paralelo.

Los GPUs más poderosos cuestan alrededor de USD40,000.-. Aquí es donde entra Nvidia, la principal empresa insignia que los fabrica.

Los procesadores más potentes son los H100 de Nvidia. Dada su capacidad de procesamiento y complejidad de cálculos que pueden realizar, Estados Unidos de Norteamérica (país donde reside Nvidia), prohibe a China adquirir estos procesadores (cuestiones de geopolítica y liderazgo mundial como pueden imaginar). Hoy en China los más potentes que se pueden conseguir son los H800, que se encuentran varios escalones por debajo.

Esta restricción de acceso a los H100 podría haberse visto como una barrera insuperable para competir con las grandes empresas de IA. Sin embargo, fue precisamente esta limitación la que empujó a los ingenieros de DeepSeek a cuestionar los fundamentos del entrenamiento de IAs. En lugar de intentar compensar la menor potencia con más cantidad de procesadores H800, se preguntaron algo más básico: ¿realmente necesitamos toda esa precisión en cada cálculo? Esta restricción los forzó a repensar desde cero la eficiencia del procesamiento, similar a cuando un chef tiene que crear un plato gourmet con ingredientes limitados y se ve obligado a maximizar el potencial de cada elemento.

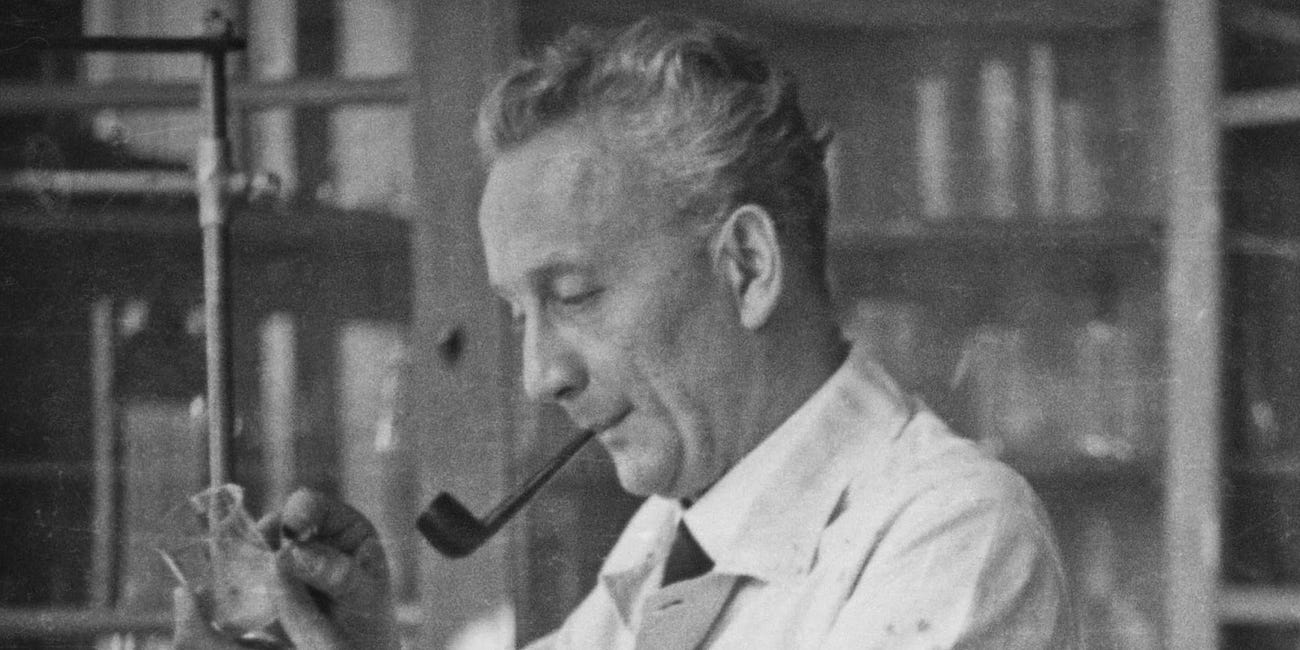

El de la foto se llama Liang Wenfeng y es el fundador de DeepSeek. Pero antes de ingresar al mundo de la IA, creó una empresa de inversión en fondos de valores, HighFlyer. Con esta empresa hizo una fortuna increíble. Su éxito consistió en comprar los mejores GPUs que tenía a su alcance y utilizar IA y Machine Learning para realizar operaciones de trading con la máxima precisión. Con ese tremendo éxito y una fortuna que ni sus tataranietos podrán gastar, decidió tener un proyecto paralelo: construir una Inteligencia Artificial de nivel "humano" y aprovechar todos los GPUs que había adquirido:

Liang crea DeepSeek con una visión poco convencional para formar su equipo. En lugar de seguir el camino tradicional de Silicon Valley de reclutar veteranos de grandes empresas de IA, contrata a docenas de doctores en data y computación de las mejores universidades chinas, buscando mentes brillantes que no estuvieran contaminadas por las formas establecidas de pensar sobre IA. Esta decisión fue estratégica: quería investigadores que pudieran cuestionar los fundamentos mismos del desarrollo de IA, sin estar atados a las reglas no escritas de la industria. Les plantea entonces el problema a resolver como un desafío de pensamiento lateral: cómo poder construir un modelo a la altura de OpenAI o Anthropic con procesadores mucho menos poderosos. La diversidad de especializaciones del equipo (desde expertos en optimización matemática hasta especialistas en arquitectura de sistemas) fue clave para abordar el problema desde múltiples ángulos. Un tremendo reto creativo que requería lograr un modelo top a 1/20 del costo, pero con la ventaja de tener mentes frescas dispuestas a cuestionar cada supuesto del desarrollo de IA.

Cuando más me adentraba en esta historia, más me emocionaba. Liang trazó un increíble desafío creativo, llenó de restricciones y con objetivos muy ambiciosos.

Toda esta situación me hizo recordar a una escena de la película Apollo 13: 'tenemos que hacer que esto quepa adentro de esto'. En aquella misión espacial, los ingenieros de la NASA enfrentaron algo casi imposible: adaptar un filtro cuadrado a un conector redondo usando solo los materiales disponibles dentro de la nave. Con vidas en juego y un tiempo límite brutal, no podían esperar por una solución perfecta, tenían que crear una solución factible con lo que tenían a mano.

DeepSeek enfrentó su propio momento Apollo 13. Con el acceso bloqueado a los procesadores más potentes, su equipo de ingenieros se encontró en una situación similar: tenían que lograr un rendimiento de nivel mundial con recursos limitados. Y al igual que los ingenieros de la NASA, no buscaron replicar la solución ideal, reinventaron completamente el enfoque. La presión de las restricciones los llevó a cuestionar cada supuesto básico del entrenamiento de IAs: ¿Necesitamos realmente tanta precisión? ¿Es esta la única forma de procesar el lenguaje? ¿Debemos mantener todo el conocimiento activo constantemente?

INNOVACIÓN 1

Precisión necesaria

Los ingenieros de DeepSeek repensaron todo el problema de cero. La IA tradicional es como escribir cada número con 32 decimales. DeepSeek dijo: “¿Qué pasaría si solo usáramos la cuarta parte? Sólo 8 decimales.”

💥 BOOM: sigue siendo lo suficientemente preciso con un 75% menos de memoria. Y esto abrió la puerta a algo más grande.

INNOVACIÓN 2

Lector experto

Un token es una unidad de información que un modelo de inteligencia artificial utiliza para entender y procesar datos, especialmente en el procesamiento de lenguaje natural (PLN).

Por ejemplo, si le das una frase a un modelo de IA como “Me gusta el chocolate”, el modelo no procesa las palabras completas de manera directa. En cambio, divide la frase en “tokens”, que pueden ser palabras, partes de palabras o incluso caracteres, dependiendo de cómo esté configurado el modelo. En este caso, los tokens podrían ser: “Me”, “gusta”, “el” y “chocolate”.

La otra gran idea de los ingenieros de DeepSeek surgió de una observación fundamental sobre cómo los humanos procesamos el lenguaje. Mientras observaban cómo los modelos tradicionales leían palabra por palabra, uno de los investigadores planteó: “¿Por qué procesar el texto como un estudiante de primaria cuando podríamos hacerlo como un lector experto?” Los lectores avanzados no leen palabra por palabra, sino que captan frases o incluso oraciones completas de un vistazo. Esta analogía con la lectura humana llevó al equipo a experimentar con el procesamiento de tokens múltiples. Probaron diferentes enfoques: primero con pares de palabras, luego con frases cortas, hasta llegar a unidades más grandes de significado. Cada iteración mostró mejoras, pero el verdadero avance vino cuando lograron que el modelo procesara oraciones completas manteniendo la precisión.

Esto es muy importante, porque cada token en un modelo tiene un costo (energético, de cómputo), de USD0.06 cada 1,000 tokens (aprox). Imaginen cuánto se reducen los costos entre procesar mil palabras versus procesar mil oraciones con la misma precisión.

De esta forma el modelo en lugar de leer como una niña de 6 o 7 años, lee frases completas a la vez.

💥💥 BOOM EXPONENCIAL: el modelo es 2 veces más rápido y 90% más preciso.

Este avance en velocidad permitió repensar algo aún más fundamental.

INNOVACIÓN 3

Expertos dormidos

Aprovechando la nueva velocidad y eficiencia, DeepSeek dio el siguiente paso: ¿Por qué tener todos los expertos despiertos todo el tiempo? Todos las IA actuales (ChatGPT, Claude, Gemini…) son modelos masivos que intentan saberlo todo. Algo así como que una persona sea Médica Clínica, Ingeniera, Abogada, Psicóloga, etc… DeepSeek tiene expertos especializados que solo se activan cuando es necesario.

Esto significa que todos los parámetros, toda la data que conforman el conocimiento de los modelos tradicionales está activa todo el tiempo. Mientras que DeepSeek sólo activa toda esa información cuando se le requiere. De esa forma, el modelo en lugar de tener 1,8 billones de parámetros activos, solo tiene 37 mil millones activos a la vez.

Imaginen que cada consulta realizada a ChatGPT es como entrar a un enorme auditorio donde todos los expertos del mundo están sentados y atentos, listos para responder: biólogos marinos, abogados, médicos, arquitectos, chefs, historiadores... Cada vez que haces una pregunta como “¿cuántos centímetros son 15 pulgadas?” o “¿qué puedo cocinar con brócoli?”, todos estos expertos están pensando una respuesta, consumiendo energía, aunque solo necesites a un matemático o a un chef. Es como tener encendidas todas las luces de un estadio para iluminar solo el banco de suplentes.

DeepSeek dio vuelta completamente esta lógica con un pensamiento lateral brillante:

¿Y si, en lugar de tener a todos los expertos atentos todo el tiempo, creamos un sistema de “dormitorios especializados”?

Cuando llega una pregunta, solo se despiertan los expertos relevantes. Una consulta de cocina activa el área de gastronomía, una duda legal despierta a los abogados, una pregunta de programación activa a los desarrolladores. Es como tener un sistema inteligente de iluminación que solo enciende las luces necesarias en cada momento.

Esta reconceptualización total del problema no solo mejoró la eficiencia energética, sino que cambió fundamentalmente la forma en que pensamos sobre la arquitectura de la IA. En lugar de construir un sabio universal que mantiene todo su conocimiento activo constantemente, DeepSeek creó una biblioteca viva donde el conocimiento se activa selectivamente según la necesidad.

💥💥💥 BOOM DISRUPTIVO: solo utiliza expertos cuando los necesita, reduciendo los parámetros activos de 1,8 billones a 37 mil millones.

RESULTADO FINAL

Se genera un Efecto Cascada con cada innovación. Cada una de ellas no solo resuelve un problema específico, sino que abre la puerta para la siguiente mejora:

Menos memoria → Mayor velocidad → Especialización inteligente

Un modelo que hace más, consumiendo menos, y costando una fracción.

¿Recuerdan cuando hablamos de las diferencias entre la innovación incremental y la innovación disruptiva?

Ser radical o ser incremental

Un tiempo atrás descubrí que nunca definí qué significaba idea en Creative Workout. Para que no se haga una mala costumbre, voy a continuar con la definición de términos básicos que utilizamos en este newsletter. Hoy, la innovación.

Todas estas pequeñas mejoras que introdujo el equipo de DeepSeek son innovaciones incrementales. Pequeños avances en distintos puntos de un proceso ya establecido. Pero al haberse dado de forma conjunta, generaron una disrupción. Porque demostraron que si trabajas sobre un determinado problema con límites claros y definidos, tus ideas pueden generar un salto cualitativo en la ejecución

En resumen, hay data muy concreta sobre estas mejoras:

- Costo de capacitación del modelo: USD100 millones reducido a USD5 millones.

- GPU necesarias: 100,000 reducido a 2000 unidades.

- Costos de API: 95 % más baratos.

Y algo que permite el acceso a más personas en relación a esta tecnología es que puede ejecutarse en GPUs para juegos de unos USD4,000.- en lugar de placas con un costo de USD100,000.-.

Claro que OpenAI, Anthropic, Microsoft o Google no se van a quedar donde están. Para el momento en que lean este artículo, ya estarán implementando estas innovaciones. Lo bueno de todo esto es que la eficiencia entró en escena. Ya no será una cuestión de quien tiene más dinero para generar más procesos de computo, sino cómo poder hacer más con lo que tenemos.

Tal como les conté sobre la filosofía de diseño de Apple y el toro de Picasso:

Obtener el mayor resultado posible, con la menor cantidad de elementos disponibles.

Esto es un punto de inflexión en la carrera de la Inteligencia Artificial. La IA está a punto de volverse mucho más accesible y mucho menos costosa. La pregunta no es si esto afectará a los actores actuales, sino con qué rapidez.

Porque hay un punto muy importante que me olvidé comentarles antes, todo esto es código abierto. Esto significa que cualquiera puede leer el esquema de diseño utilizado por DeepSeek y hacerlo (sí, claro, si tienen los recursos disponibles). Lo cual es una gran diferencia con los modelos tradicionales, que son una caja negra donde nadie sabe cómo se crearon e implementaron.

¿Y a donde vamos ahora?

En mi opinión personal esto nos muestra un camino claro: los modelos de IA como ChatGPT, Claude, Gemini, Copilot o DeepSeek serán un commodity. Un producto básico y estandarizado, que se intercambia en mercados sin importar quién lo produce.

Los modelos de IA están dando saltos agigantados cada 2 o 3 semanas. Seguir el ritmo de estas mejoras es agotador. Para una persona cualquiera, la diferencia entre el modelo GPT4 y 4mini no es mucha, porque son mejoras incrementales. La gran disrupción es la que les acabo de contar: la eficiencia en el entrenamiento.

ChatGPT no tiene la delantera entre estas empresas porque tiene el mejor razonamiento, sino porque hizo de la herramienta algo súper sencillo de utilizar. En vez de hacerle una pregunta a Google y que te de cientos de resultados repletos de links sponsoreados y publicidad paga, GPT te brinda la respuesta que buscabas. Nada de cosas raras, tipeás lo que necesitas y ya.

Hay una gran oportunidad para quienes buscamos una gran idea todo el tiempo. Es cómo adaptamos estas tremendas herramientas para brindar una solución en nuestro día a día.

Aquellas personas que puedan construir una interfaz entre estos modelos y un problema concreto a resolver, serán quienes puedan construir ideas rentables y eficientes.

Los hábitos de las personas nunca serán un commodity, si creas una herramienta a la que la gente recurre sin pensar: 💥 ¡Boom!

Deepseek demostró que es posible hacer más con menos, pero más importante aún, reveló una verdad fundamental sobre la innovación en la era digital: la próxima gran revolución tecnológica no necesariamente vendrá de quien tenga los mayores recursos, sino de quien sepa repensar los problemas desde sus cimientos. Es un recordatorio de que la verdadera disrupción a menudo surge de las restricciones, no de la abundancia.

Este caso nos enseña que cuando nos enfrentamos a limitaciones aparentemente insuperables, la respuesta no está en forzar el camino tradicional con más recursos, sino en cuestionar los supuestos fundamentales que damos por sentado. DeepSeek no solo optimizó el proceso existente, lo reinventó por completo. Es la diferencia entre intentar hacer que un motor de combustión sea más eficiente y atreverse a imaginar un motor eléctrico.

Estamos en un punto de inflexión en la carrera de la inteligencia artificial, y lo que suceda a continuación está a nuestro alcance. Mucho más que unas semanas atrás. Porque DeepSeek no solo democratizó la tecnología de IA, sino que demuestra una vez más que las grandes innovaciones suelen nacer cuando nos atrevemos a cuestionar lo imposible y convertir nuestras limitaciones en catalizadores de creatividad.

¡Gracias por leer Creative Workout! Espero que te haya sido valioso. Si así fue, compártelo con tus contactos o en redes sociales para que más personas puedan aprovecharlo.

Si tienes comentarios, responde este mail o escríbeme por Linkedin.

¡Nos vemos la próxima semana! 🤘👨🏻💻🤘

Emma